El control del mundo atiborrado de máquinas inteligentes transcurre sin acuerdos de valores de quienes construyen esos sistemas

Haga click para ampliar la imagen

La inteligencia de la computadora superará a la inteligencia humana en el siguiente milenio siempre y cuando se tenga en cuenta el costo total de cualquier solución, ya que hasta ahora todas las decisiones han requerido conjuntos sustanciales de ingenio humano y no mayor computación con cantidades desmesuradas de datos. Mientras llega ese futuro se debate acerca de los valores inculcados en las personas y en las instituciones con los que se construye la tecnología anclada en un principio de la psicología: diseño elaborado por personas (naturaleza) versus aprendizaje de máquinas a partir de datos (nutrición).

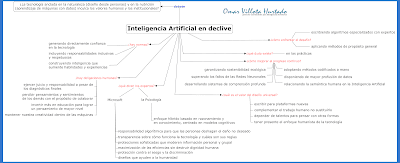

La acción de la tecnología en los últimos 70 años de investigación en Inteligencia Artificial (IA) y Aprendizaje Automático (AA) desambigua e interpreta datos en tiempo real a costa de acentuar en el aprendizaje de propósito general y en los conjuntos de entrenamiento cada vez con mayor y más y más computación. Significa entonces que mediante la IA un individuo experimentaría el mundo de maneras muy provechosas. Por tanto, para afianzar el progreso continuo del campo IA, ¿debemos enfrentar los nuevos desafíos aplicando métodos de resolución de problemas de propósito general o escribir algoritmos especializados diseñados por expertos para cada problema en particular?

Prototipos singulares sobre lo incierto de la tecnología se encuentran a diario: en las transformaciones de la imagen del mundo visual a un entorno audible (la audio descripción para personas con limitación visual), en la escucha de las voces artificiales de los asistentes digitales personales que “leen” textos, en las estrategias de los juegos por computadora (ajedrez informático y aplicaciones Go), etc. En concepto general “la IA que se está implementando en aplicaciones afecta ya la vida de las personas de manera crítica y personal”, sostiene el estudio de septiembre 2021 Gathering Strength, Gathering Storms: The One Hundred Year Study on Artificial Intelligence (AI100) de la universidad de Stanford.

En términos de Microsoft Corporation usados para su patente US 9.427.185 B2 del 30 ago. 2016, sobre User behavor monitoring on a computerized device, “... no hay intención de limitar la invención a formas específicas, sino que, por el contrario, el propósito es cubrir todas las modificaciones, construcciones alternativas y equivalentes que caen dentro del espíritu y alcance de la invención.” Por ejemplo, interpretación de los datos para aprobaciones de préstamos, sentencias penales, atención médica, cuidado emocional y recomendaciones influyentes en múltiples ambientes.

De manera que los humanos con la implementación de la IA estaremos mejor favorecidos en el marco conceptual pero hay dudas en la práctica. Según publicaciones en blog de Richard Sutton, líder en aprendizaje por refuerzo, “La lección más grande que se puede leer en 70 años de investigación en IA es que los métodos generales que aprovechan la computación son, en última instancia, los más efectivos y por amplio margen” y de Rodney Brooks, profesor emérito de robótica Panasonic en el MIT, en respuesta que “Esto resuena con un modo de pensar actual entre muchos de los nuevos participantes en la IA que es mejor diseñar redes de aprendizaje y poner cantidades masivas de potencia informática, que tratar de diseñar una estructura para computación especializada de alguna manera para la tarea.”

¿Habrá progreso continuo?

En las décadas de 1960 y 1970, desde el inicio de la investigación al campo IA, con base en argumentos de Herbert Simon −premio Nobel de Economía− y de Alan Newell −ganador del Premio Turing−, se trataron de construir métodos de propósito general que fueron fácilmente superados en la década de 1980 con el conocimiento especializado codificado a mano a través de sistemas expertos.

Durante la década de 2010 se superaron dichos métodos especializados ajustados a mano, cuando la adición del big data y de los procesadores más rápidos permitieron métodos de propósito general como el Aprendizaje Profundo (AP). Ahora, en la década de 2020, estos métodos generales se están ejecutando en los límites, y muchos académicos investigadores del campo IA se preguntan, ¿cómo podremos mejorar un progreso continuo? Hay por lo menos cuatro fuentes con la respuesta.

En opinión de Gary Marcus, profesor emérito de psicología y ciencia neuronal de la universidad de New York, “no tenemos ninguna esperanza de lograr una inteligencia sólida sin desarrollar primero sistemas de comprensión profunda, que implica capacidad de correlacionar y discernir patrones sutiles en conjuntos de datos complejos y también operatividad para mirar cualquier escenario y abordar preguntas como las que podría formular un periodista: quién, qué, dónde, por qué, cuándo y cómo.”

Para el Panel de Estudio sobre IA 2021, los “métodos generales están llegando a límites, tales como: cómputo disponible, tamaño del modelo, sostenibilidad, disponibilidad de datos, fragilidad y falta de semántica. Todas están influyendo para que los investigadores regresen al diseño de componentes especializados de sistemas. Para continuar progresando, los investigadores de IA probablemente necesitarán adoptar métodos codificados a mano para fines generales y especiales, así como procesadores cada vez más rápidos y datos más grandes.” Esas necesidades de construir modelos tan grandes aumentarán la huella de carbono en el ambiente ecológico.

El taller convocado para el segundo reporte del Estudio Cien Años sobre Inteligencia Artificial expone la existencia de otros límites, según la experiencia de informáticos e ingenieros, académicos en ciencias sociales y humanidades (incluidos antropólogos, economistas, historiadores, académicos de medios, filósofos, psicólogos y sociólogos), expertos en derecho y en políticas públicas, y representantes de la gestión empresarial y de los sectores público y privado.

Dichas restricciones al progreso continuo del campo IA a saber ya no tienen relación con la potencia del procesamiento que se duplicaba cada dos años más o menos sino con extremos cuánticos y costes de desarrollo. Superarlos significa construir hardware especializado, optimizado, que admita software de IA como el Tensor de Unidades de Procesamiento (TPU) de Google. Son chips versión 4 que brindan poder crítico y promesa de mayor velocidad en capacitación para el aprendizaje automático. Anunció el CEO de Google, Sundar Pichai que “… nuestra próxima generación, la TPU v4 estará conectada entre sí en super computadoras, llamadas pods, donde un solo módulo v4 contiene 4096 chips, y cada módulo tiene 10 veces el ancho de banda de interconexión por chip a escala.”

Otro borde a retar es el tamaño del modelo, desde mayo 2020 establecido en GPT-3. Es un modelo de lenguaje de red neuronal con 175 billones de parámetros o sea más de diez veces más grande que el tamaño del anterior modelo de lenguaje, Turing NLG. Un equipo de OpenAI, una empresa de investigación e implementación de IA, calculó que, desde 2012, los más grandes entrenamientos de IA han ido aumentando exponencialmente con un tiempo de duplicación de aproximadamente tres meses y medio y no dos años como aseguraba la Ley de Moore.

La disponibilidad de datos también frena el desarrollo del campo IA pues los métodos del AP necesitan a menudo conjuntos de datos con decenas de miles, cientos de miles o millones de ejemplos. Según los investigadores, no tenemos conjuntos de datos tan grandes para ciertos problemas como trasplantes de corazón y de pulmón, a pesar del deseo de construir modelos predictores de éxito. La causa se fundamenta en que, aun cuando hay datos limitados disponibles para entrenar sistemas, la cantidad de operaciones quirúrgicas realizadas en todo el mundo son solo unas pocas centenas. Además, los métodos de Aprendizaje Automático como el Aprendizaje Profundo luchan por trabajar con datos que quedan fuera de su distribución durante el entrenamiento.

Solo estas tres fronteras (potencia del procesamiento, tamaño del modelo y disponibilidad de profusión de datos) ponen en riesgo la sostenibilidad ecológica del planeta −un cuarto motivo− debido al incremento en la huella de carbono y a los costos ambientales significativos. Un informe de 2015, On Global Electricity Usage of Communication Technology: Trends to 2030, advirtió ya que las tecnologías informática y de comunicaciones podrían consumir la mitad de la electricidad producida globalmente para la década 2030 si los centros de datos no pueden ser más eficientes. Afortunadamente, la mayoría de empresas ha estado trabajando para que sus centros de datos sean más eficientes muy rápido al cambiar a energía verde, manteniendo estable su huella de carbono durante los últimos cinco años.

Finalmente el actual CEO de Microsoft Corporation, Satya Nadella, predice que las máquinas autónomas nos llevarán a lugares, harán nuestras tareas, nos ayudarán a tomar mejores decisiones pero también podrán generar errores inducidos económicos masivos. Para el gigante del software propietario, el actual enfoque de la IA se inicia con tres principios que denomina singularidad:

- construir inteligencia que aumente las habilidades y las experiencias humanas, o sea que la tecnología posea capacidad para razonar sobre grandes cantidades de datos y para reconocer patrones rápidamente;

- generar confianza directamente en nuestra tecnología para infundir protecciones a la privacidad, la transparencia y la seguridad;

- incluir en la tecnología que se construye responsabilidades inclusivas y respetuosas con todos.

Tecnología más humanista: un marco

Para acordar una atmósfera pudorosa los diseñadores de tecnología con IA empiezan a abordar una pregunta fundamental, ¿cuáles son los principios y los valores de diseño universal que deben guiar nuestro pensamiento, diseño y desarrollo?

La perspectiva de la construcción basada en principios comienza con la plataforma sobre la que se construye tecnología IA. Es decir, el desarrollo del software se está convirtiendo en un "tercer tiempo de ejecución", que significa cuál es el sistema sobre el que los programadores establecen y ejecutan aplicaciones. Si las primeras cajas de herramientas ofimáticas se construyeron para PC en la base del procesador de texto y de las presentaciones hoy se escriben para la Web con hipertexto. No obstante, las herramientas de productividad y de comunicaciones que vendrán deberán escribirse para una plataforma completamente nueva, que administre información, aprenda del contexto de la información e interactúe con el mundo físico.

El auge de la computación inteligente competente conlleva por tanto modificaciones: de las percepciones sobre la inteligencia de las máquinas y de los comportamientos humanos por las relaciones informáticas. De manera que los líderes empresariales deben de estar comprometidos con diseños de tecnología que complementen el trabajo humano en lugar de sustituirlo, pues la sola automatización no provoca mayor o menor igualdad. Dependemos de talentos para construir nueva forma de pensar ya que la botella lanzada al océano contiene el mensaje “navegamos por la distorsión, la disonancia y la dislocación” pues no está acordado el marco ético y empático que funcione como estrategia de ingeniería a largo plazo.

Los sistemas informáticos existentes también son bastante frágiles, siendo un quinto limitante. Recientes ataques de adversarios demuestran que los métodos actuales de IA a menudo están propensos a errores cuando se utilizan en nuevos contextos debido, principalmente, a que la inteligencia humana se degrada por distracción. Según estudios de Ian Goodfellow, Jonathon Shlens y Christian Szegedy, científicos informáticos en Google, la vulnerabilidad de la perturbación adversaria radica en la naturaleza lineal de las redes neuronales que genera fallos generalizados.

Por ejemplo, un solo píxel modificado en un objeto puesto, en una orientación y un contexto no canónicos, a la entrada del sistema de reconocimiento de imagen puede clasificar un bus amarillo de transporte escolar como una banana. Por supuesto, nuestra visión humana puede ser fácilmente engañada también pero de maneras muy diferentes a los sistemas de visión artificial. Hay otros casos típicos ya no con imágenes sino con textos, presentados en el evento NeurIPS por el profesor Marcus:

1- Ayer dejé mi ropa en la tintorería y todavía no la recojo. ¿Donde esta mi ropa? … en casa de mamá. Este modelo de lenguaje de red neuronal predice correctamente la categoría de elementos que sigue al fragmento de la consulta (es decir, una ubicación) pero no logra realizar el seguimiento correcto de dónde se encuentra la tintorería.

2- Observé a seis ranas en un tronco. Dos se van y tres se unen. … El número de ranas en el tronco ahora es diecisiete. Ese caso nuevamente predice correctamente la categoría de respuesta (un número) y nuevamente no logra captar los detalles.

Y un límite final es el relacionado con la semántica. Los métodos de IA tienden a ser muy estadísticos y entienden el mundo de maneras bastantes diferentes a lo idiosincrático de los humanos. El traductor de idiomas de Google que utiliza Aprendizaje Profundo traduce "el teclado está muerto" y "el teclado está vivo" palabra por palabra, sin hacer pausa para pensar. Pero esa metáfora funciona muy bien en la primera traducción que en la segunda como podríamos entender UD y yo.

Incluso habría que considerar cuatro obligaciones humanas para dejar de ignorar al enfoque humanista: a) percibir pensamientos y sentimientos de los demás con el propósito de colaborar y construir relaciones fundamentales; b) invertir más en educación para lograr un pensamiento de mayor nivel y resultados más equitativos; c) mantener nuestra creatividad dentro de las máquinas que la seguirán enriqueciendo y aumentando; y d) ejercer juicio y responsabilidad humanos a pesar de los diagnósticos finales generados por computadora. Se trata de tecnología con enfoque más humanista.

Para Nadella, la industria y la sociedad deberían discutir seis fundamentos relacionados con el campo IA: “diseños que ayuden a la humanidad; transparencia sobre cómo funciona la tecnología y cuáles son sus reglas; maximización de las eficiencias sin destruir la dignidad de las personas; protecciones sofisticadas que moderen la información personal y grupal; responsabilidad algorítmica para que los humanos puedan deshacer el daño no deseado y protección contra el sesgo para evitar el existente uso con fines de discriminación.”

Cynthia Breazeal, ingeniera del MIT Media Lab, argumenta que “de todas las especies, somos los más sociales y emocionales pero dedicamos poco tiempo a pensar en esas empatías con que experimentamos el mundo a través de las comunicaciones y la colaboración.” Según propone Marcus, en su ensayo The Next Decade in AI: Four Steps Towards Robust Artificial Intelligence, un paso es “… un enfoque híbrido, basado en el razonamiento y en el conocimiento, centrado en modelos cognitivos, que podría proporcionar el sustrato para una IA más rica y robusta de lo que es en la actualidad.”