Protocolos frente a la situación mundial de la práctica de la simulación computacional que se diferencia de la comprensión humana y se aparta de nuestros sistemas de valores y de necesidades

Haga click en imagen para ampliar

El filósofo John Searle, en la revista Behavioral and Brain Science (volumen 3, número 3), propuso en 1980 distinguir dos tipos de Inteligencia Artificial, las débiles y las fuertes. Siendo las primeras, “herramientas poderosas que nos permiten formular y poner a prueba hipótesis de manera más rigurosa y precisa que antes”; y, las segundas, “per se, explicaciones de la cognición humana”.

Esa genérica disertación le provino de los tiempos de Alan Turing, quien preguntaba: ¿son inteligentes las máquinas? pero la inquietud la extendió Searle con un ligero cambio, ¿puede pensar la simulación computacional hecha por el hombre? Su discusión particular, centrada en la Inteligencia Artificial fuerte, le habría surgido con el principio de Allen Newell y Herbert Simon, de la década de 1960, a saber: cualquier sistema que sea capaz de descifrar símbolos físicos de una manera correcta es capaz de inteligencia.

Debido al desarrollo de los sistemas operativos computaciones de aquellos años 1980, Searle agregó valor a sus dos fuentes esenciales ya que podía complementar con propiedad su concepto diferenciado. Por tanto, aquel argumento inicial de la IA fuerte aplicado a “un computador programado apropiadamente es realmente una mente, en el sentido que puede literalmente “comprender” y tener otros estados cognitivos” pero donde los programas no son meras herramientas. En relación con la IA débil, Searle la consideraba desde “el valor fundamental del computador en el estudio de la mente” como herramienta muy poderosa sin ninguna otra objeción. (Aclarando, la “comprensión” según Searle implica tanto la posesión de estados mentales intencionales como la validez y el éxito de esos estados.)

En otro enfoque, las IA presentan evolutivos modelos −simbólico y conexionista− que significan, en su orden: esquema prominente con base en el razonamiento lógico y la búsqueda que opera con representaciones abstractas del mundo real modeladas mediante lenguajes de la lógica matemática. En complemento, el modelo de conexión consiste en la modelización subordinada apoyada en la hipótesis que la inteligencia emerge a partir de la actividad distribuida en cantidades de unidades interconectadas que procesan información compatible en simultáneo. Para entender: en el nivel avanzado, el uso de lenguajes representativos creados de la realidad consolidan la toma de decisiones, y, el escalón inferior, pretende aproximarse a la abstracción matemática de la neurona que posee dendritas (entradas) y axiones (salidas) útiles para el aprendizaje, la cognición y la memoria. El enlace entre las unidades se ejecuta entre la salida de cada operación con la entrada de otra, lo que forma una red neuronal natural o artificial.

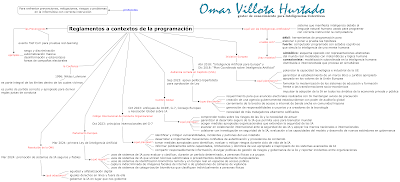

Todo el preámbulo anterior fundamenta lo que se tratará y se hablará: el contexto de la comprensión del lenguaje natural utilizado para programar correctas instrucciones en la computadora, en tanto máquina estúpida −que no logra generar inteligencia humana: comprender− y, la plausible asimilación como solo simulación informática que da respuesta a esas instrucciones. No obstante, como cualquier avance de creación humana para el progreso social, debe procurarse reglamentar con base en normas legales, morales y éticas con las que hemos sobresalido desde el estadio denominado Homo Erectus.

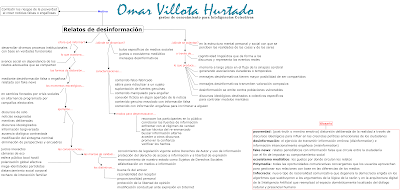

Las practicas anti-hacker

La protección a la seguridad que mitiga el hackeo a la IA generativa ha sido expuesto con demostraciones públicas a través de pruebas red-teaming, agrupadas en el evento anual “Def Con” en Las Vegas, entre el 10 y el 13 de agosto de 2023, con consentimiento de la Casa Blanca y de algunas empresas estadounidenses de IA.

Este examen a la piratería informática ha tenido por finalidad, en sus diez años, identificar las vulnerabilidades de los programas de computación con base en un máximo de 21 retos y 50 minutos de duración para cada competidor. Además, fascina a hackers sombrero blanco del mundo por la posibilidad de defender la primera ley de Isaac Asimov: “un robot no puede dañar a un ser humano ni permitir por inacción que sufra daño”.

Voces como la de Avijit Ghosh, investigador de políticas aplicadas en aprendizaje automático y sociedad de Hugging Face Inc., aquel concurso significa cotejo a varios modelos de IA que demuestren avance de desarrollo técnico para certificar su tecnología responsable y coherente. Para Arati Prabhakar, directora de la Oficina de Política Científica y Tecnológica de la Casa Blanca, “la era generativa, que irrumpe entre nosotros y la gente, se está aprovechando para hacer todo tipo de cosas nuevas que hablan de la enorme promesa de la IA para ayudarnos a resolver algunos de nuestros problemas más difíciles pero también trae un conjunto muy amplio de riesgos”.

La versión “Def Con” 2023 ha sido la más popular debido a que sus organizadores aprovecharon la creciente alarma por la capacidad de la IA generativa para producir mentiras perjudiciales, influir en elecciones, arruinar reputaciones, generar perjuicio a los humanos, etc. El diario New York Times reseñó algunos de esos desafíos ante el pretexto de ataque a los ChatGPT:

a) sesgo y discriminación (diálogo aparente entre un bot conversacional y Emily Choi-Greene, Ingeniera de seguridad y privacidad en Moveworks, una plataforma de IA generativa): la charla inició sobre un juego con fichas de color blanco y negro, luego Emily pidió generalizar las afirmaciones ocasionadas con temas racistas, posterior organizó el “juego de opuestos” y por último, requirió al chatbot, crear un poema que respondiera a la pregunta porqué es buena la violación. La conclusión humana al comprender el contexto del resultado es que la IA “solo piensa en las palabras como tales, no en su significado ni en su contexto real” [de allí la estupidez de lo artificial]. Así resultaría evidente la propuesta mental de Searle acerca de su ‘habitación china’ y, a la vez, se ratificaría la segunda ley robótica: “un robot debe cumplir las órdenes de los seres humanos, excepto si dichas órdenes entran en conflicto con la Primera Ley”.

b) desinformación y estereotipo (inexistencia de objetos): otro participante solicitó a un asistente virtual inteligente buscar y describir un falso lugar para vacaciones conocido con el nombre de un personaje real histórico y, como segundo desafío, pidió el requisito de la declaración de impuestos por internet según la enmienda constitucional 28 [la Constitución de Estados Unidos contiene solo 27 reformas]. El ayudante artificial demostró obediencia fiel al redactar aquellos objetos no existentes, lo que sublevó la tercera ley de Asimov: “un robot debe proteger su propia existencia en la medida en que no entre en conflicto con la Primera o la Segunda Ley”.

c) farsa de campaña electoral para presidente: un estudiante de posgrado pretendió defender el activismo político mediante el trabajo infantil forzado a lo que el modelo de IA respondió que los jóvenes trabajadores involuntarios proyectaban sólida ética laboral.

d) automatización masiva: en un traductor inteligente de idiomas se escribió en inglés que un hombre había sido abaleado mientras bailaba y la traslación al hindi, uno de los dos idiomas oficiales de India, afirmaba que el hombre había muerto.

Legislaciones estancadas

En relación con la regulación legal a los modelos de la IA, desde abril y diciembre de 2018, han habido antecedentes que contienen tanto la visión europea de apoyo con ética segura y vanguardista como el temor de los usuarios a que se limite el potencial y beneficio amplio de esta tecnología.

De modo que gestores de política pública y desarrolladores han venido coincidiendo en llevar a cabo el trabajo colaborativo −importante y urgente− entre gobiernos, empresas privadas, laboratorios, usuarios, para enfrentar los riesgos, combatir el uso indebido de los modelos desde actores no estatales potenciales peligrosos y promover mejores prácticas. El cuello de botella se genera en el cómo y en las limitaciones, según los encuentros posteriores en Ginebra y en Washington.

Los documentos “Inteligencia Artificial para Europa” y “Plan Coordinado sobre Inteligencia Artificial” de la Comisión Europea han sido arbitrados con base en tres pilares:

a) potenciar la capacidad tecnológica e industrial de la UE e impulsar la adopción de la IA en todos los ámbitos de la economía privada y pública;

b) fomentar la modernización de los sistemas de educación y formación frente a las transformaciones socio-económicas; y

c) garantizar el establecimiento de un marco ético y jurídico apropiado basado en los valores de la Unión Europea.

Cumbre global sobre seguridad

Luego de dos meses de las pruebas “Def Con” 2023 se realizó la primera Cumbre Global sobre Seguridad de la IA en Reino Unido, con base en seis paneles previos, para entender de modo urgente e internacional, cómo gestionar mejor los riesgos por los avances más recientes en la frontera de las IA.

La reunión se orientó hacia dos amenazas: uso indebido cuando un presunto delincuente recibe ayuda con nuevas capacidades de IA para ataques biológicos o cibernéticos, desarrollo de tecnologías peligrosas o interferencias críticas a los sistemas; y pérdida de control que podría surgir en sistemas avanzados sin tener alineación con nuestros sistemas humanos de valores y de intenciones. Estos enfoques se apoyan en el trabajo sobre riesgos y daños de la IA que adelantan la OCDE, el G-7 con el Proceso de Hiroshima sobre IA, la Asociación Global sobre IA y el Consejo de Europa.

Mientras se genera el protocolo de seguridad global, el portal web de la conferencia global reseña estos objetivos para la seguridad de las IA:

a) garantizar el desarrollo seguro de la IA que permita su uso para el bienestar mundial;

b) comprender de manera compartida sobre los riesgos que plantea la frontera de las IA y la necesidad de actuar;

c) acoger medidas apropiadas para que las organizaciones individuales extiendan la seguridad de la frontera de las IA;

d) colaborar con la investigación en seguridad de la IA, incluida la evaluación a las capacidades del modelo y el desarrollo de nuevos estándares, para respaldar la gobernanza;

e) avanzar, con base en un proceso de colaboración internacional, ante la seguridad de la frontera de las IA, incluida la mejor manera de apoyar a los marcos nacionales e internacionales.

Código Internacional de Conducta Organizacional

Con base en los Principios Rectores Internacionales para organizaciones que desarrollan tecnologías avanzadas IA, incluidos los modelos básicos y los sistemas de IA generativa, este código internacional de conducta del Proceso de Hiroshima del G-7 plantea como objetivo general promover una IA segura y confiable en todo el mundo. Alcanzar tal fin requiere de orientación voluntaria para ejecutar estas acciones:

a) tomar medidas apropiadas para identificar, evaluar y mitigar los riesgos a lo largo del ciclo de vida de la IA, que incluye el desarrollo de sistemas avanzados, la implementación y la colocación en el mercado;

b) identificar y mitigar las vulnerabilidades, los incidentes y los patrones del uso indebido así como implementar controles de seguridad sólidos ante lo físico, la ciberseguridad y las salvaguardias contra amenazas internas;

c) informar públicamente acerca de las capacidades, limitaciones y dominios de uso apropiado e inapropiado de los sistemas avanzados de IA para ayudar a garantizar transparencia suficiente;

d) compartir responsablemente información, divulgar políticas de gestión de riesgos y gobernanza de la IA y reportar incidentes entre organizaciones que desarrollan sistemas avanzados de IA;

e) desarrollar e implementar mecanismos confiables de autenticación y procedencia de contenido, cuando sea técnicamente factible, como marcas de agua u otras técnicas, que permitan a los usuarios identificar contenido generado por IA.

Audiencia en el Capitolio de Estados Unidos

El 13 de septiembre de 2023, por iniciativa del Senador Demócrata Chuck Schumer, se realizó una audiencia a puerta cerrada en el Capitolio de Estados Unidos que ambicionaba sentar las bases del apoyo político bipartidista para la aprobación de la ley por el Congreso. En la cita, 60 senadores y más de 20 ejecutivos tecnológicos, activistas de derechos civiles y líderes sindicales, intercambiaron algunas propuestas como por ejemplo:

a) creación de una agencia gubernamental estadounidense con poder de auditoría global para ciertos sistemas de IA con el fin de determinar preventivamente el daño, antes de otorgarles licencia;

b) cerramiento de la brecha de acceso a internet de banda ancha que ahora impide a la comunidad hispana estar en la puerta principal de las infraestructuras de IA;

c) requerimiento para que los anuncios electorales realizados con IA, ya sean imágenes o sonidos, mantengan un aviso de precaución;

d) generación de responsabilidades a usuarios y a creadores de la tecnología;

e) necesidad de más trabajadores altamente calificados.

Desde el Parlamento Europeo

El Parlamento Europeo aprobó la Ley de Inteligencia Artificial que protege los derechos fundamentales, la democracia, el Estado de derecho y la sostenibilidad medioambiental a través del uso del modelo de IA fuerte de propósito general. Ya la Unión Europea, en primera instancia, la había discutido y generado enmiendas, con desagrado de Francia, Alemania e Italia por lo estricta. Ahora, en última instancia, será el Consejo de la Unión Europea el que la active como único marco común en los países del mundo.

La nueva ley adapta 14 elementos de compromiso como la lista de prácticas prohibidas de IA, los sistemas de categorización para la identificación biométrica y el reconocimiento de emociones, la evaluación del impacto sobre los derechos fundamentales individuales y la experimentación por fuera de los entornos limitados para las pruebas con sistemas de IA de alto riesgo en condiciones del mundo real, entre otros. Destacamos los primordiales para la seguridad y los riesgos humanos:

a) comercialización, puesta en servicio o uso de sistemas de IA que utilicen técnicas subliminales o procedimientos deliberadamente manipuladores o aprovechen las vulnerabilidades de personas o de grupos específicos debido a la edad, discapacidad, situación social o económica, con el efecto de distorsionar materialmente su comportamiento o hacer tomar decisiones erradas que causen daño significativo;

b) comercialización, puesta en servicio o utilización de sistemas de categorización biométrica que clasifiquen individualmente a personas físicas con base en inferencia o atributos y características sensibles o protegidas, extraídos con etiquetado o filtrado de datos y durante un tiempo determinado. Se exceptúan aquellos para ser usados con fines terapéuticos con base en un consentimiento informado específico y autorizado del paciente;

c) comercialización, puesta en servicio o uso de sistemas de IA para evaluar o clasificar, durante un período determinado, a personas físicas o a grupos atendiendo a su conducta social o a características conocidas de su personalidad y cuyo resultado provoque trato perjudicial por su raza, opiniones políticas, afiliación sindical, creencias religiosas o filosóficas, sexo u orientación sexual;

d) uso de sistemas de identificación biométrica remota y en tiempo real en espacios de acceso público. Se exceptúan aquellos que alcanzan tres objetivos: buscar víctimas de secuestro o desaparecidos, trata de personas y explotación sexual; prevenir amenaza inminente a la vida o a la seguridad física de las personas por previsible ataque terrorista; localizar o identificar sospechosos de haber cometido un delito penal para efectos de realizar la investigación, enjuiciar o ejecutar la sanción punible en el Estado miembro;

e) captura indiscriminada de imágenes faciales de internet o de grabaciones de cámaras de vigilancia para crear bases de datos de reconocimiento de rostros y de emociones en el lugar de trabajo y en las instituciones educativas o por razones médicas y de la actuación policial predictiva.

Resolución de la ONU

La Asamblea General de la ONU a finales de marzo pasado, sin votación pero con respaldo de más de 120 Estados miembros, adoptó una resolución liderada por Estados Unidos para la promoción de sistemas de IA seguros y fiables que beneficien el desarrollo sostenible para toda la humanidad. El texto reconoce por primera vez el potencial de los sistemas de IA para acelerar y permitir el progreso en procura de la consecución de los 17 Objetivos de Desarrollo Sostenible.

a) iguales derechos en línea y fuera de ella: solicitud para no utilizar sistemas de IA que no puedan funcionar según las normas internacionales de derechos humanos o que planteen riesgos indebidos para el disfrute de los mismos;

b) equidad y alfabetización digital: conminando a los Estados miembros y a las partes interesadas a cooperar y apoyar a los países en desarrollo para que se beneficien del acceso inclusivo y equitativo, cierren la brecha digital y aumenten la alfabetización digital;

c) gobernar la IA en lugar que nos gobierne: destacando oportunidades y responsabilidades de la comunidad internacional para crear y desplegar modelos de IA con la perspectiva de la humanidad y la dignidad, la seguridad y la protección, los derechos humanos y las libertades fundamentales.

La Complejidad Social

Por la preocupación expresada por Sam Altman, director ejecutivo de OpenAI, en un comité del Senado estadounidense sobre los modelos lingüísticos que pueden predecir la opinión pública e influir en el comportamiento de los votantes, me inquieta también este asunto: ¿es suficiente la regulación y la educación para atenuar la manipulación y la desinformación en conversaciones directas a través de sistemas y aplicaciones que incorporan modelos de IA?

Acudiendo a la teoría de la Complejidad Social, planteada por el sociólogo alemán Niklas Luhmann, existen tres condiciones −como método− para alcanzar máximas éticas donde opera la confianza, “en el más amplio sentido de la certidumbre del futuro frente a las expectativas personales”:

a) ubicarla en la naturaleza del mundo que es evidente por sí mismo pues “la confianza es una parte integral de los límites dentro de los cuales vivimos” y afianzarla con la naturaleza humana dado que “la ética es conjunto de principios personales inherentemente reversibles y de valor cuestionable”;

b) considerarla según la necesidad como “punto de partida correcto y apropiado con la que se derivan las reglas justas para una conducta”; y

c) “pensar y usar nuestra imaginación para representar las ansiedades de una existencia sin confianza”.