Una investigación a docentes de Ciencia Política en países prósperos postindustriales reveló esta tripleta: una generalizada inclinación de la ideología izquierda liberal que estaría aislando a los conservadores, una experiencia en los campus universitarios de empeoramiento a tolerar el debate abierto académico pluralista y una carencia de respecto por el sólido debate intelectual

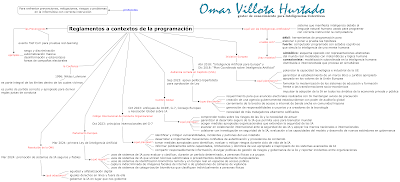

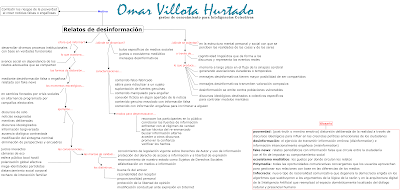

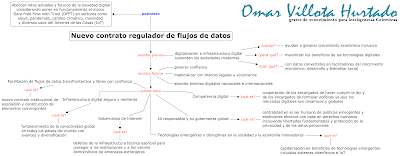

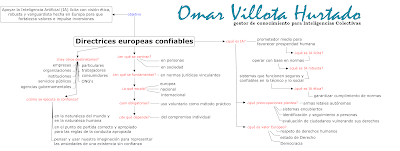

Haga click en imagen para ampliar

Se observa un consenso amplio entre los académicos de la disciplina ciencias políticas de Estados Unidos y de sociedades occidentales potentadas, sobre el deterioro de la libertad académica para enseñar e investigar. Ese escenario reflejaría la transformación estructural, tanto en educación superior como en la variación ideológica.

Así concluye la profesora de política comparada en Harvard durante tres décadas, Pipa Norris, en su documento de trabajo con docentes de ciencia política acerca de la 'cultura de la cancelación' en los campus universitarios.

La encuesta global “World of Political Science (WPS), 2019” obtuvo 1.245 respuestas recopiladas de profesores, quienes estudian o trabajan en 23 sociedades postindustriales. Como condición mediadora se efectuaron comparaciones por cohortes de nacimiento, por género y sondeos transnacionales en Alemania, Australia, Canadá, Estados Unidos, Italia, Nigeria, Países Bajos, Reino Unido, Rusia y Suiza.

La medición recopiló información entre el 3 de febrero hasta el 7 de abril de 2019, mediante un cuestionario en línea de Qualtrics sobre múltiples dimensiones de la vida y el trabajo profesional, incluidas peculiaridades sociales, prioridades del rol, orígenes nacionales, calificaciones, habilidades metodológicas y el subcampo temático de especialización. Incluso 22 ítems monitorearon la experiencia directa acerca de los cambios en la profesión durante los últimos cinco años y, otros tres aspectos de la vida académica se usaron para saber si habían mejorado, no habían cambiado o habían empeorado. Estos fueron: el respeto por el debate abierto desde diversas perspectivas, las presiones para ser 'políticamente correcto' y la libertad académica para enseñar e investigar.

Se preguntó a los encuestados: “A menudo se piensa que la vida académica está en estado de cambio. Utilizando la escala de 1 a 5, basada en su experiencia, indique si cree que la calidad de los aspectos de la vida académica ha cambiado en los últimos cinco años”. Dichos aspectos se enumeran en la sección resultados, más adelante.

La descomposición de la investigación sugiere varias proposiciones argumentales abiertas que surgen de la tesis de la cultura de la cancelación y describe las fuentes de evidencia. Validadas ante la prueba empírica de las encuestas al profesorado, se examinan afirmaciones del tipo: una ortodoxia progresista ha condenado a los contrarios al ostracismo, la libertad académica se ha limitado, el conformismo se ha fortalecido y el sólido debate intelectual se ha arrinconado.

Con base en los datos, se deduce que la experiencia personal de la cultura de la cancelación empeora y varía entre los académicos de ciencias políticas, según sean sus identidades ideológicas de izquierda-derecha, su cohorte de nacimiento generacional y su género, y el tipo de sociedad en desarrollo en la que viven, estudian y trabajan. Se han manifestado dos premisas, al respecto.

La primera tesis de la cultura de la cancelación se refiere a las identidades ideológicas de los politólogos a través de afirmaciones sobre sus valores y sus creencias predominantes en las culturas universitarias. Quiere decir que hay una idea enquistada entre el profesorado acerca de la hegemonía liberal que silencia las voces conservadoras. En efecto, la encuesta pionera representativa de 1958 de Paul Lazarsfeld, a gran escala con científicos sociales estadounidenses, demostró que los académicos tendían a ser más comprensivos con los valores liberales o de izquierda que la población general.

La radical y acalorada política universitaria de las décadas 1960 y principios de 1970 desencadenó más investigaciones sobre creencias y valores políticos en los profesores universitarios. Alrededor del 46% de los científicos sociales encuestados en 1976 se identificaron como de izquierda o liberales, el 28% como conservadores y el 26% como moderados. Este patrón no se limitó únicamente a los campus estadounidenses, pues ya había sesgos similares en Reino Unido en 1971.

En 2007 aquella evidencia se actualizó con otra encuesta a gran escala con profesorado estadounidense, “The social and political views of american professors”, demostrando que ─a pesar que muchos tenían opiniones moderadas de centro─ los conservadores y los republicanos siguen siendo relativamente raros entre los profesores de las universidades norteamericanas, especialmente en ciencias sociales. Más reciente, en 2016 se revisaron cinco importantes encuestas con académicos estadounidenses, realizadas desde 2000, y concluyeron que el porcentaje de conservadores auto-identificados oscilaba entre 5% y 15% en ciencias sociales y entre 4% y 8% en humanidades.

En Europa el análisis de datos agrupados de la Encuesta Social Europea 2019, “Are universities left-wing bastions? The political orientation of professors, professionals, and managers in Europe”, sugiere que los profesores de 31 países de la unión suelen ser más liberales y de tendencia izquierdista que otras profesiones equivalentes como abogados, arquitectos y médicos. Otro contraste evidencia que los valores y las actitudes políticas de los académicos frente a la redistribución económica y la integración en la Unión Europea están lejos de ser homogéneos.

En síntesis, el conjunto de estudios de la sociología de la academia desde finales de 1950 ha observado la generalizada inclinación de la izquierda liberal, al menos en las sociedades postindustriales. Se puede esperar que esto se perciba igual en la disciplina de ciencia política.

La premisa dos relacionada con la experiencia del empeoramiento de las libertades académicas manifiesta también el sesgo progresista en el campus, aun cuando no implica necesariamente intolerancia por el debate pluralista o que las opiniones contrarias no sean bienvenidas o que las ideas sean silenciadas. El análisis más fuerte ante la tesis de la cultura de la cancelación concierne a si se piensa que aquella práctica de conducta se ha deteriorado.

Asumiendo importantes limitaciones relacionadas con las insuficientes encuestas empíricas, la mayoría del profesorado liberal en los dos contextos geográficos delimitados puede acertadamente no ser consciente de cualquier sesgo hegemónico. Aún si lo reconociera, le resta importancia como problema grave. En antinomia, también se puede esperar que la minoría de académicos conservadores este más propensa a expresar preocupación por el deterioro de las libertades si tiene experiencia directa de la cultura de la cancelación. Podría, este grupo, estar más de acuerdo con las crecientes restricciones a la libertad de expresión académica, las presiones para la conformidad ideológica y la imposición de un discurso políticamente correcto.

En consecuencia, se reportan equivalencias entre Estados Unidos y el mundo próspero al comparar las experiencias del cambio de las condiciones de mejora o decadencia entre académicos auto-identificados como conservadores y liberales en ciencias políticas.

Resultados

Las invitaciones a los politólogos para participar de la encuesta de 2019 se distribuyeron a través de las redes sociales Facebook, Twitter y correos electrónicos; mediante la lista del boletín informativo del European Consortium for Political Research (ECPR) que agrupa doce universidades europeas; por las listas de la International Political Science Association (IPSA) ─fundada en París en 1949 bajo la égida de la Organización de las Naciones Unidas para la Educación, la Ciencia y la Cultura (UNESCO)─ y a través de asociaciones varias nacionales como Canadian Political Science Association (CPSA), Political Studies Association (PSA) de Reino Unido y Australia, y Rusia.

A grandes rasgos, los tres items acerca del respeto por el debate abierto, las presiones para ser políticamente correcto y la libertad académica para enseñar e investigar son indicadores válidos desde la experiencia sobre diversas afirmaciones de las tesis de la cultura de la cancelación, incluyendo que los campus universitarios han visto empeorar la tolerancia al debate pluralista y a los puntos de vista opuestos, existen presiones crecientes para ajustarse a las prevalecientes normas sociales (progresistas o liberales) y a formas de expresión en la educación superior. Adicional, hay percepción de estar reducidas la libertad y la autonomía académicas para que los académicos individuales persigan sus intereses a través de la enseñanza y la investigación.

Politólogos a la izquierda

La pregunta “En términos generales, ¿cómo se describiría usted habitualmente ante la ideología?” recogió 1.733 respuestas de politólogos en el mundo y 221 en EE.UU. Fue inicialmente diseñada en el cuestionario en una escala móvil (0 a 10), desde el más izquierdista (0) hasta el más derechista (10) pero para el análisis posterior, esa escala se simplificó en izquierda (0-5) y derecha (6-10). La distribución de datos mostró curvas normales con un sesgo positivo a la izquierda, de 0.495 en el mundo y de 0.737 en EE.UU. Ese enfoque seguiría mostrando la tendencia hegemónica de 1958.

La puntuación media de los encuestados en todo el mundo fue de 4,53 en la escala de 0 a 10. En total, la mayoría de los politólogos (58%) de todo el mundo se considera ubicados a la izquierda moderada del espectro ideológico, mientras que otro 14% se posicionó en la "extrema izquierda". Poco más de una cuarta parte (26%) de los politólogos de todo el mundo se posicionó como de derecha moderada, aunque al mismo tiempo menos del 2% se consideraba de "extrema derecha".

Por su parte, la media estadounidense fue de 3,16 en la escala de 0 a 10. Siendo dos tercios de los politólogos estadounidenses (65%) auto-considerados de izquierda moderada, un pequeño grupo adicional (15%) se consideraba de extrema izquierda. En cambio, en general una quinta parte (20%) se consideraba de derecha moderada y casi ningún encuestado se consideraba de “extrema derecha”.

Para la profesora Norris, la falta de diversidad intelectual en la cultura académica puede ser problemática dentro de la disciplina ciencia política, especialmente en áreas controvertidas como la política de raza, género, poder y desigualdad. El enfoque, por tanto limita perspectivas alternativas para cuestionar los valores normativos prevalecientes y las teorías empíricas integradas en la agenda dominante de la investigación.

Respeto al debate abierto y a la libertad académica

La distribución de las evaluaciones con base en la experiencia del respeto al debate abierto desde diversas perspectivas en la vida académica, indagó si aquella vivencia ha cambiado para mejor o para peor durante los cinco años anteriores. En general, se muestra una curva de Media igual a 3,16 (en la escala 1 a 5: mejoro mucho, mejoro poco, no cambio, empeoro mucho, empeoro poco).

Si se desglosa por la medida dicotómica de la identidad ideológica de izquierda-derecha, se observan algunas diferencias modestas. Los profesores de izquierda (36%) son más propensos a sentir que la calidad del debate sigue igual en los últimos años según su experiencia. Por el contrario, los profesores de derechas (15%) son ligeramente más proclives a creer que el debate abierto ha empeorado mucho con el tiempo.

La pregunta sobre libertad académica proporciona un indicador importante sobre la calidad de la vida intelectual y de los sentimientos de autonomía en la profesión docente e investigadores. La pluralidad más grande (49%) a la izquierda ideológica pensó que desde su experiencia, la libertad académica se había deteriorado “algo/mucho”. Otro tercio (35%) no informó cambios, mientras que una quinta parte (17%) respondió que la libertad había mejorado “algo/mucho”. Sin embargo, los profesores de derecha (39%) pensaban que la libertad académica se había deteriorado “algo/mucho”, y (36%) daba por hecho que había mejorado “algo/mucho”.

Presiones para ser políticamente correcto

Se preguntó a los docentes acerca de ¿cómo han cambiado las percepciones de las presiones para ser “políticamente correcto” en la vida académica, durante los últimos años? El concepto se refiere a la conformidad con las normas sociales predominantes, una forma de autocensura de palabras y acciones auténticas diseñadas para encajar y evitar el oprobio.

Este tema evidencia preocupación más clara y compartida por ambos lados del espectro ideológico. De nuevo, la pluralidad de encuestados auto-identificados a la izquierda (42%) informó que, en su propia experiencia, no notaba cambios con el tiempo.

No obstante, 45% de ellos y 60% de la derecha informó que estas presiones habían empeorado “algo/mucho” con base en su experiencia. Estas percepciones superaron la proporción en general que sentían más positivamente que estas presiones habían mejorado “algo/mucho” (14% y 19% en su orden, según la ideología).

Comparaciones transnacionales

Al comparar los diez países diversos citados al inicio de este contenido, con un mínimo de al menos 70 encuestados, se muestran experiencias notablemente similares especialmente en las democracias angloamericanas que comparten tradiciones históricas y semejantes sistemas de educación superior.

El patrón clasificado de académicos de derecha de ciencias políticas que reporta peores experiencias de la cultura de la cancelación es Canadá, Australia, EE.UU., Reino Unido, Países Bajos, Rusia, Alemania, Italia y Suecia, en menor medida. La excepción es Nigeria, donde no hay diferencias significativas entre izquierda y derecha.

Así mismo, en todos esos países excepto Nigeria, las respuestas a la pregunta sobre la experiencia de presiones para ser políticamente correcto muestran una distribución similar, con mayores experiencias de este tipo reportadas por académicos auto-identificados de derecha.

Conclusión

Pipa Norris expresa que existen genuinos motivos de preocupación frente a la evolución de la cultura de la cancelación, que parten de la crítica legítima a palabras y a hechos socialmente ofensivos hasta convertirse en erosión a la tolerancia de la disidencia, sofocación a la libertad de expresión e imposición de una tendencia progresiva de ortodoxia de izquierda entre administradores, profesores y estudiantes.

Los datos de la encuesta WPS confirmaron el sesgo de docentes de izquierda en la disciplina de la ciencia política. Sin embargo, el nivel de desequilibrio entre izquierda y derecha no se debe exagerar por cuanto la mayoría de los académicos auto-describieron su posición ideológica en el espectro político como “moderadamente izquierdista”, en lugar de “extrema izquierda” y algo más de la cuarta parte de los politólogos de todo el mundo se identificó como “moderadamente derechista”.

La evidencia del estudio presentado configuró un Índice de Cultura de la Cancelación resumido, donde se reflejan variación de dirección según el tipo de sociedad en comparación y crecientes restricciones a la libertad de expresión académica con base en la experiencia, presiones para el conformismo ideológico y la aplicación de un discurso políticamente correcto. Los modelos comparables sugieren que en Estados Unidos y en 23 sociedades postindustriales, los politólogos auto-identificados de derecha eran más propensos a informar sobre una experiencia personal de empeoramiento de la cultura de la cancelación, y quienes se identifican como de izquierda en 78 sociedades en desarrollo informaron el mismo deterioro.

A pesar de la poca evidencia comparada, lo anterior podría atribuirse a factores tales como: el papel del desarrollo socioeconómico y la modernización, los patrones de la libertad de expresión, la democratización y el tipo de régimen en cada sociedad, la polarización del partidismo político, el rol de las remotas tradiciones culturales y los contrastes estructurales en las instituciones y en las políticas de la educación superior.

Otra explicación plausible puede estar soportada en el concepto clásico de la “espiral de silencio”, desarrollado hace casi cuatro décadas por Elisabeth Noelle-Neumann, según el cual por miedo al aislamiento social o a la pérdida de estatus, las personas no expresan sus opiniones auténticas para evitar contrariar a las normas sociales predominantes. En verdad, valdría la pena fusionar esta teoría con la Cultural Backlash: retóricas populistas autoritarias que han alterado la política en muchas sociedades, como Donald Trump en Estados Unidos y el Brexit en Reino Unido que han socavado la confianza pública de la legitimidad de la democracia liberal.

Datos de encuestas transnacionales y de series temporales, incluidas las Encuestas de Valores Europeas y Mundiales, demuestran que los valores socialmente conservadores suelen seguir prevaleciendo como opinión mayoritaria en muchos países en desarrollo. Se incluyen actitudes, creencias y valores sobre cuestiones sociales como la división de los roles sexuales entre mujeres y hombres, las identidades de género no binarias, la homosexualidad y los derechos LGBTQ, las opiniones tradicionales sobre la sexualidad, la familia y el matrimonio, la importancia de la religión y los sentimientos de nacionalismo y nativismo.

En contraste, el equilibrio en la opinión pública ha ido cambiando gradualmente en dirección más liberal y progresista hasta convertirse en la opinión mayoritaria en muchas sociedades postindustriales ricas de Europa Occidental y de América del Norte. Tales cuestiones presionantes del cambio han sido los derechos LGBTQ, la secularización, la igualdad de género, la diversidad étnica y la inclusión racial. Esta alteración ha alcanzado a los grupos de vanguardia como la generación más joven de estudiantes y las poblaciones de profesores con educación universitaria.

Procesos bien documentados del cambio cultural generacional a largo plazo en muchas sociedades occidentales significan que la proporción de quienes sostienen valores tradicionales socialmente conservadores han experimentado un punto de inflexión en las últimas décadas, a medida que el grupo pasa del estatus hegemónico a uno minoritario en los campus universitarios y en la sociedad. En últimas, está aumentando la polarización ideológica y partidista.

Por último, con base en indicadores desglosados del índice compuesto, resaltan algunos contrastes observables importantes: dado el predominio del liberalismo progresista en los campus universitarios, los profesores de izquierda pueden simplemente no ser conscientes de la experiencia de sus colegas más conservadores y negar por tanto el problema. Otro tanto dejaría ver que la intensa polarización sobre cuestiones de identidad política los hace poco comprensivos con esas afirmaciones. Entre los académicos de ciencias políticas, puntualmente se observa un consenso más amplio sobre el deterioro de la libertad académica para enseñar e investigar, lo que puede reflejar modificaciones estructurales más amplias tanto en la educación superior como en los cambios ideológicos.

Auto-críticas a este estudio WPS consisten en que la encuesta está restringida a la disciplina ciencia política por lo que no se pueden observar generalizaciones similares en disciplinas como sociología, economía, psicología social; en humanidades y ciencias naturales.

Además, cierra la pregunta a los académicos sobre su identidad ideológica y su experiencia directa frente a los cambios en la profesión. Esa practica prolongada es inseparable de la práctica de las percepciones a la academia pues aquellas per se son importantes para la construcción social de la realidad.

En consecuencia, sería útil realizar otras mediciones para explorar experiencias más profundas como por ejemplo, si los politólogos conservadores sintieron que no habían sido designados o promovidos debido a sus opiniones políticas, si habían participado en la organización de eventos públicos que luego se cancelaron o si alguna vez se sintieron incómodos al hablar en reuniones de la facultad o en el aula debido a sus valores.