Australia, Estados Unidos, India y Japón, países miembros del Diálogo de Seguridad Cuadrilateral (Quad), publicaron un conjunto de principios sobre tecnología donde refuerzan el énfasis en el "ecosistema tecnológico abierto, accesible y seguro"

Haga click para ampliar

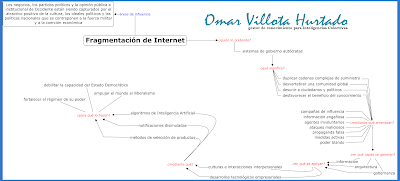

Este ideal de Internet, que se mantiene desde su creación, se contrapone al que desean imponer Rusia y China y otros estados autócratas para una Internet fragmentada, lo que sería extremadamente costoso, ineficiente en términos de carbono y poco práctico para no hablar de sus técnicas de manipulación, tanto abiertas como encubiertas.

Para expertos como Graham Webster, investigador académico de Stanford University Cyber Policy Center, y Justin Sherman, miembro no residente de Atlantic Council’s Cyber Statecraft Initiative, “dividir Internet a nivel de infraestructura, en dos o más redes independientes, significa duplicar cadenas de suministro altamente complejas”. Así mismo, Hillary Clinton -cuando fue Secretaria de Estado- públicamente expuso que el ideal de "una Internet, una comunidad global y un cuerpo común de conocimiento nos beneficia y nos une a todos".

El desarrollo del tecno-globalismo sentó un ideal sin precedente, después de la Guerra Fría. Diplomáticos, académicos y tecnólogos confiaron y siguen creyendo en aquel libre intercambio abierto como una virtud en sí misma y como único medio para difundir las libertades democráticas de la razón, la política y la economía. Los más utópicos no lo creyeron al punto que, según datos del Banco Mundial, el acceso a Internet y sus beneficios siguen siendo muy desiguales en todo el mundo. Pero las amenazas por campañas de influencia, propaganda falsa, agentes involuntarios, ataques maliciosos, información engañosa, medidas activas, y sobre todo, el poder blando de Rusia y China y otros, están presionando a las democracias para fragmentar Internet.

Infraestructura abierta, pero ¿segura y confiable?

Diferentes gobiernos en diversos momentos han actualizado sus estrategias nacionales de ciberseguridad. India considera a la actual y futura tecnología de la información como “motor crítico del crecimiento de su economía”. Japón aprobó una “ley para evitar ataques rusos como el Olympic Destroyer” frente a sus Olimpìcos 2020 o la Estrategia Internacional para el Ciberespacio ahora “fomenta una infraestructura de comunicación abierta, interoperable, segura y confiable, que respalda al comercio internacional, refuerza a la seguridad internacional e impulsa a la libre expresión y a la innovación”.

Y más reciente, el plan de participación cibernético de Australia en 2015 que alerta en modo proactivo su enfoque de la seguridad cibernética, “invirtiendo recursos para cumplir los desafíos de un entorno cibernético complejo ya que puede incluir pérdidas económicas, daños a la reputación, pérdida de capacidad a la propiedad intelectual e interrupción del negocio” y, Alemania en 2018 que aprobó la Ley de Aplicación de la Red (NetzDG) con la intención de mejorar el cumplimiento de la ley para las redes sociales.

Para Laura Rosenberger, Directora de Alliance for Securing Democracy, algunos demócratas no han reconocido que todas las actividades de la Red ocurren a través de tres dimensiones integradas: información (propagación, control y persuasión con base en narrativas), arquitectura (sistemas y plataformas que transmiten, arreglan, ordenan y recopilan información) y gobernanza (leyes, normas y estándares de contenido, datos y tecnología, en algunos casos) pero sobre todo, tampoco han comprendido completamente lo que ya tienen claro China y Rusia: los dominios del ciberespacio y el entorno de la información convergen cada vez más.

El momento tecnopolar como denomina Ian Bremmer, Presidente del Grupo Eurasia, a la vida en el espacio digital que los gobiernos no pueden controlar por completo, está fuertemente apoyado en los desarrollos de las empresas de tecnología que ejercen un modo de soberanía sobre el comportamiento de los ciudadanos en las plataformas digitales. También dan forma a culturas e interacciones interpersonales mediante notificaciones disimuladas que envían golpes de dopamina al cerebro, algoritmos de inteligencia artificial que completan lo que se escribe y métodos de selección de productos que afectan las compras.

Aquellas maneras de la infraestructura abierta orienta a las personas a emplear su tiempo, buscan oportunidades profesionales y sociales y, en última instancia, imponen ideas y pensamientos. Es un poder en el espacio digital que corre mientras las instituciones continúan caminando por el mundo físico. Una segunda forma en que las tecnológicas se diferencian de las empresas fordistas es que ofrecen más espectro conectivo de productos digitales.

Actualmente cuatro empresas -Alibaba (China), Amazon, Google y Microsoft (americanas)- satisfacen globalmente la mayor demanda mundial en servicios mediante información en la nube, arquitectura de infraestructura informática y gobernanza que proviene del propio código web. Así ya no importa mucho si el mundo es real o qué se necesita para dirigir la sociedad moderna. La pregunta clave es si esta infraestructura abierta es segura y confiable, cuando la rodea la idea generalizada de una Internet fragmentada.

Poder blando

Para el profesor Joseph Nye, el concepto poder blando surge del atractivo positivo de la cultura, los ideales políticos y las políticas nacionales, que se contraponen a la fuerza militar y a la coerción económica. En efecto, la nueva influencia de las élites autoritarias de Rusia, China, estados de Asia, África y Oriente Medio se desarrolla en tres áreas principales:

- negocios, donde los gobiernos autócratas invierten en sectores principales del extranjero para obtener beneficios y para ganar influencia dentro de los países anfitriones. Su peor consecuencia en las economías occidentales es la captura de profesionales locales que dependen del patrocinio y se convierten en serviles del tiempo de trabajo y del valor del salario. Cotejar los contratos que Angola paga a banqueros y contables para que blanqueen el dinero y cortejan a los políticos que están dispuestos a defenderlos o los $3 mil millones de dólares de las élites azerbaiyanas con que financiaron pagos personales, lavado de dinero y compras de artículos de lujo en Europa.

- partidos políticos, que es el nivel más básico y que algunos estados autoritarios financian a través de organizaciones y amigos políticos. Confrontar los casos de apoyo financiero de Rusia a partidos de extrema derecha como el Frente Nacional de Francia, Jobbik de Hungría, Alternativa para Alemania en Alemania o los acuerdos de cooperación con el Partido de la Libertad de Austria y la Liga del Norte de Italia.

- opinión pública e institucional que apoyan usando medios de comunicación, medios sociales, organizaciones no gubernamentales, think tanks e instituciones culturales. Ver como ejemplos las compras de medios de Portugal por angoleños, la cadena de televisión internacional RT de Rusia que ha buscado fracturar las sociedades y los gobiernos occidentales y socavar la fe pública de la democracia liberal desacreditando a las instituciones y funcionarios democráticos mediante medidas activas, los Institutos Confucio de China que funcionan por el mundo como brazo del estado chino ignorando la libertad académica o la difusión agresiva de normas dentro de instituciones internacionales, como la Unión Internacional de Telecomunicaciones -órgano de Naciones Unidas- para cubrir su represión a las libertades en Internet.

A nivel mundial, aquellas minorías pretenden inclinar el orden global hacia el iliberalismo democrático y sus objetivos incluyen además a organizaciones internacionales como ONU, UE y OTAN. Según Ivan Krastev, Presidente del Centro de Estrategias Liberales de Sofía (Bulgaria), “el populismo es un fenómeno global pero en la actualidad no está claro qué es. Por un lado, captura la naturaleza de los desafíos que enfrenta la democracia liberal con peligrosas mutaciones y por el lado contrario, se opone a la naturaleza representativa de las democracias modernas, a la protección de los derechos de las minorías y a las restricciones a la soberanía del pueblo, un rasgo distintivo de la globalización.”

Argumenta Thorsten Benner, Director del Global Public Policy Institute en Berlín, que “los estados autoritarios en los últimos años han buscado audazmente influir en las democracias occidentales para fortalecer sus propios regímenes, debilitar la capacidad de los estados occidentales por desafiar el autoritarismo y para empujar al mundo hacia el antiliberalismo.” Razón por la cual, sugiere desinfectantes en las democracias como transparencia, regulaciones y campañas de concienciación pública mediante el debate público crítico y solicita, a Estados Unidos y gobiernos de la UE, exigir a sus empresas y consultores que revelen las relaciones comerciales, incluso con clientes de estados autoritarios, y a las organizaciones sin fines de lucro, clubes deportivos, grupos religiosos, universidades y partidos políticos que aclaren los fondos que reciben y las condiciones que se les imponen.

China en America

A pesar que Google restringe al tecnológico chino Huawei el uso de Android, China sigue avanzando en la región -con aumento exponencial- en el mercado de los teléfonos inteligentes, donde su cuota de mercado en América Latina pasó de 2,3% en 2013 a 9,4% en 2018, según cifras de la consultora Euromonitor.

La desconfianza hacia China estriba a las redes 5G de telefonía móvil que desarrolla Huawei, aun cuando la empresa ha negado repetidamente que sea espía del gobierno de China. Una segunda defensa advierte que la prohibición "solo servirá para obligar a Estados Unidos a aceptar alternativas peores y más costosas".

Dice Ricardo Mendoza, analista para dispositivos móviles en América Latina de International Data Corporation (IDC), que Huawei se colocó en el top 3 en muchos países de la región como México, Colombia, Perú, Chile, y también en Centroamérica, pero a última hora desistió de las economías de Argentina y Brasil. Además, Tina Lu, analista de la consultora Counterpoint, destaca que en Colombia, Huawei se convirtió en la segunda marca más grande en 2018 con una cuota de mercado de 25%.

La marca china Huawei se observa en aeropuertos, clubes deportivos, selecciones nacionales de fútbol de Panamá, equipos peruanos Alianza Lima y Sporting Cristal; Santa Fe de Colombia; Emelec de Ecuador; América de México; Bolívar de Bolivia; Boca Juniors, River Plate en Argentina, entre otros. En México, Huawei se ha enfocado en dos sectores estratégicos: los jóvenes y los segmentos premium.

Por su parte, el sistema de la democracia soberana de Putin evita que la peligrosa mayoría esté representada políticamente, según el analista Krastev.

Según Latinobarómetro 2020, cerca de 40 de cada 100 ciudadanos de América Latina creen que las grandes empresas tienen poder en su país, siendo esta percepción la idea para que los populistas locales acepten a estados autoritarios e influyan en la democracia.