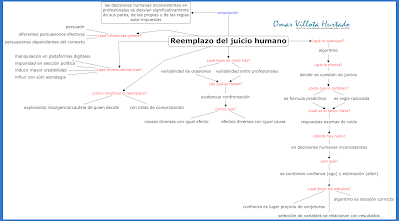

Algunos empresarios, con base en auditorías, han ingresado el algoritmo en los procesos como el elemento más radical que reemplaza el juicio humano inconsistente de los profesionales

|

Haga click en imagen para ampliar |

Daniel Kahneman y Linnea Gandhi, profesores de psicología y ciencias del comportamiento, afirman que el estado de ánimo y el clima ambiental cambian las decisiones de una persona y califican como ruido a esa variabilidad causal de los razonamientos. La razón prima en que “la decisión es cuestión de juicios” y se apoya en el cómputo, que siempre devuelve el mismo resultado para un idéntico proceso según sea cualquier entrada.

Las decisiones humanas inconsistentes en los empleados de una misma organización son diarias, arbitrarias, insidiosas, poco confiables. Algunos trabajos estarían libres de ese ruido si tomamos algunos que valoran las existencias, estiman precios a bienes raíces, condenan a delincuentes, evalúan el desempeño del puesto de trabajo, auditan estados financieros, etc. No obstante, las actividades humanas que deben mantener estrictas reglas, que se limitan al juicio objetivo para así garantizan respuestas idénticas en casos idénticos, se pueden alejar de la consistencia o generar diagnósticos incorrectos. Quien toma decisiones coherentes las realiza con base en procedimientos y prácticas establecidas con normas precisas e información exacta pero la investigación académica ha confirmado que en muchas tareas aquellas decisiones no consistentes de expertos son volubles.

Existen dos fenómenos cotidianos relacionados con el impedimento a reconocer que el juicio de los demás contiene ruido:

- los profesionales experimentados tienden a tener alta confianza para la exactitud de sus propios juicios y

- aquellos experimentados obtienen, en consecuencia, gran estima de sus colegas por esa inteligencia.

Esta combinación (confianza -ego- y estimación -alter-) conduce inevitablemente a una sobre notoriedad del acuerdo. Es análogo a lo que ocurre con la apurada redistribución de los memes en las plataformas de medios sociales: las personas esperan que los pensamientos de los demás estén mucho más cerca de los suyos propios y los comparten, como resultado de ese proceso mental. El sociólogo alemán Niklas Luhmann afirmó que “la confianza humana se funda en la motivación atribuida a la conducta, y la conducta sentada en la experiencia -de la cual depende la confianza- debe aparecer como una expresión y reafirmación de la personalidad.”

Imaginemos que, luego de revisar un expediente de préstamo, empleados de alguna sucursal de un mismo banco dejen de seguir las mismas pautas corporativas y respondan distinto, de modo antojadizo, frente a lo causal. Aquella sucursal tendría entonces muchos clientes o ningún cliente afectado. Además de la propia reputación del banco. Ahora supongamos la situación de toma de decisiones por fuera de las pautas tecno-científicas o legales con médicos, jueces, directores de proyectos, en general con profesionales convocados a examinar, juzgar, orientar, construir, etc. guiados por la experiencia y el conocimiento tácito y por principios generales en lugar de reglas rígidas. ¿Es aceptado el rol de tomador de decisión si se espera que sus decisiones contengan invariable causal en sus juicios? Este fue el resultado al evaluar el examen de dos patólogos ante la gravedad de una biopsia: la correlación entre sus calificaciones fue de 0,61 (siendo 1 lo perfecto), baja pero indica que hicieron diagnósticos inconsistentes frente al mismo tejido examinado.

Otro tipo de variabilidad repetida en los juicios de los profesionales son contradictorios, entre los razonamientos previos y los siguientes para ocasiones diferentes. Sea este experimento estereotipo: se pidió a siete profesionales de desarrollo de software, en dos días distintos, que estimaran las mismas sesenta tareas para tres meses cuyo esfuerzo de trabajo se apoyara en procesos no mecánicos e inconscientes. El resultado obtenido fue que 6 de las sesenta tareas se estimaron 2 veces. Es decir, una misma información presentada al mismo individuo en diferentes ocasiones produjo distintas estimaciones de esfuerzo. Para los autores de la prueba, ingenieros del "Simula Research Laboratory" de Oslo, “el alto grado de inconsistencia en las estimaciones de esfuerzo para la misma tarea en los profesionales del software, medida por un mismo estimador, arrojó una diferencia promedio de hasta 71%”.

La primera proposición inevitable de las decisiones humanas inconsistentes es que los profesionales, a menudo, toman decisiones que se desvían significativamente de las de sus pares, de sus propias decisiones previas y de las reglas que ellos mismos afirman seguir. Una causa de lo invisible de este ruido en esa clase de toma de decisiones es que las personas no pasan por la vida imaginando alternativas plausibles para cada juicio que realizan.

Tipos de ruido y de correccionesLos experimentos a varios profesionales independientes en auditoría al ruido o en evaluación, ante algunos casos reales, han llevado a considerar que existen en el mundo real dos tipos de ruido: la variabilidad de ocasiones -como las decisiones que varían cuando el mismo caso se presenta más de una vez al mismo individuo-, y la variabilidad entre profesionales en el mismo rol quienes toman decisiones diferentes. A decir desde la sociología, según Luhmann, se trata de “evidenciar la confrontación que las uniones permiten: entre causas diversas con el mismo efecto o entre efectos diversos con la misma causa”.

Para modificar el primer tipo de ruido (la variabilidad de ocasiones), la operación más simple para la toma de decisiones es la lista de comprobación. De modo que chequear fomenta un enfoque coherente ante las determinaciones. Por ejemplo, si la sentencia a un expediente emitida por un funcionario está influenciada por su estado de ánimo o si la calidad del solicitante de un préstamo reemplaza el juicio humano inconsistente.

Para el segundo tipo de ruido (la variabilidad entre individuos con el mismo rol) el recuento ya no será tan simple pues se debe explorar la indulgencia o la cautela del tomador de la decisión. Aquí los humanos seguimos teniendo representación importante ante la acción correctiva mediante el seguimiento frecuente a nuestras decisiones o la exploración imparcial que resuelva diferencias. Es decir, la confianza humana sigue ubicada en el nivel más alto desde el cual se describen los objetivos de las decisiones como comprender el pensamiento individual, aumentar la optimización de las herramientas y mejorar la comunicación entre pares.

Entonces, ¿qué pasa con las predicciones y las decisiones asumidas mediante el algoritmo? Ante todo un algoritmo está creado para optimizar el tiempo de atención y “la atención se obtiene a través del miedo, ansiedad, lujuria, con todo lo bajo de las pasiones humanas: enojo, envidia, debilidad...” sostiene Martin Hilber, Ph.D en Comunicación de la Universidad del Sur de California y Doctor en Economía y Ciencias Sociales de la Escuela de Economía y Ciencias Sociales de Alemania. Esta es una visión determinista ya que considera al algoritmo un fin que existe por fuera de los procesos sociales del entorno de las relaciones humanas.

Para David Beer, del Departamento de Sociología de la Universidad de York (Reino Unido), por su parte, “el algoritmo se convierte en fuente de preocupación política, con datos en funcionamiento mediante decisiones algorítmicas.” Se trata, por el contrario, de procesos sociales que modelan el mundo social y se incorporan al sustrato del código informático. Estaría esta visión más cercana a la consistencia humana pues a fin de cuentas el desarrollo algorítmico tiene que ver más con los productos de la mente a partir de un contexto social.

El algoritmo: regla razonadaEn consecuencia, estamos más propensos a considerar el concepto de algoritmo como fórmula predictiva, fundamentada en el razonamiento del sentido común. Siendo así, ese modelado del mundo social se entreteje con las prácticas y con los resultados de los individuos, quienes permiten o no la circulación de los datos, la modificación y la re-codificación con el propósito de ajustar los fines.

Para quienes no han desarrollado software, la construcción de un algoritmo parece desalentador. Es cierto que un algoritmo recibe datos de entrada pero basta un pequeño número de casos o ningún dato de resultado absoluto. Lo primordial son las reglas del sentido común, reglas razonadas, que se aplicarán a los datos ingresados. El factor clave de éxito de estas fórmulas es que sus resultados estén exentos del ruido.

Los estudios han demostrado que el algoritmo es la decisión correcta siempre que el criterio único sea evitar los errores. Obvio, no lo será, cuando los entendimientos profesionales sean ruidosos como las prácticas de juicio o las decisiones que implican múltiples dimensiones o dependan de la negociación con la contra parte. Por ejemplo, conducir vehículos.

La construcción de una regla razonada comienza con la selección de pocas variables cuya condición sine qua non es que incontrovertiblemente sean relacionadas con el resultado a predecir. Digamos: si el resultado es el impago del préstamo, los activos y los pasivos se incluirán en la lista de chequeo. La siguiente actividad es asignar a esas dos variables el mismo valor en la fórmula de predicción, estableciendo su signo según la dirección lógica (positivo para activos, negativo para pasivos). La regla razonada se puede construir con unos cuantos cálculos simples, a saber: los activos son superiores a los pasivos por tanto la decisión matemática es aprobar la diferencia del valor pero si el solicitante del préstamo ha sido detenido por orden judicial la decisión humana será revertir el proceso del estudio bancario.

La segunda proposición necesaria afirma que donde existen juicios humanos habrá ruido, difícil de apreciar, y como regla general, la confianza es el lugar propicio para hacer conjeturas sobre la fiabilidad de los juicios humanos: oscilar entre un Alter y un Ego.

Influencias del algoritmo en decisiones políticasAun cuando no existe suficiente investigación académica sobre cómo los algoritmos pueden influir en las decisiones y actitudes de las personas, los profesores de la Universidad de Deusto (España), Agudo y Matute, realizaron 4 experimentos para examinar si los algoritmos pueden persuadir a las personas, de forma explícita o encubierta, en el evento previo a unas elecciones.

El resultado del estudio concluyó que i) la persuasión es posible, ii) hay diferentes estilos de persuasión, iii) los estilos de persuasión son más efectivos si dependen del contexto de la decisión y iv) es importante educar a las personas para que no sigan ciegamente los consejos de los algoritmos y desconfíen de su coherencia encubierta.

Los juicios de recomendación entre las personas parecieran que están en desuso ya que la Inteligencia Artificial (IA) ha superado esta habilidad humana. La cultura de la creencia más fácilmente ahora acoge los consejos de anónimos o de extraños que los de contactos cercanos; rápidamente redistribuimos contenido en las plataformas de medios sociales acerca de qué comprar, dónde comer, con quién salir, a dónde ir... Para expertos como Shyam Sundar, profesor en el Colegio de Comunicaciones de la Universidad del Estado de Pensilvania, los juicios desde la IA son 'sesgos de máquina' y se asumen porque fungen como objetivos, eficientes y confiables. No obstante, pocos consumidores de aquel sesgo caen en la cuenta que están siendo manipulados por los desarrolladores del algoritmo y por las empresas que orientan la toma de decisiones importantes para que a ellas les afecte.

Frente al abuso y a la moderación de la manipulación desde las plataformas digitales de medios sociales existen iniciativas institucionales. En la Unión Europea se conoce el documento público “Directrices éticas para una IA confiable”, creado en junio de 2018, con el propósito de promover una inteligencia artificial fiable apoyada en 3 componentes: a) debe ser lícita o cumplir todas las leyes y reglamentos aplicables; b) debe ser ética para que garantice el respeto de los principios y valores éticos; y c) debe ser robusta, tanto desde el punto de vista técnico como social, puesto que los sistemas de IA, incluso si las intenciones son buenas, pueden provocar daños accidentales. Otros estudios dan cuenta que con la IA se puede usar una heurística (adaptabilidad) e inferir los errores sistemáticos y predecibles como el sesgo humano con el propósito de manipular de modo sutil las decisiones humanas. Los votantes de Estados Unidos, por ejemplo, han tenido fuerte influencia que modifica su comportamiento para los periodos de elecciones de Congreso y de Presidencia desde el año 2010.

El vocablo heurística en la psicología de la persuasión no es más que la tendencia reiterativa de imitar el comportamiento de la mayoría y de los amigos (confianza) aun cuando a veces manipule el pensamiento y el comportamiento a favor de los intereses de terceros. Esta tendencia es un atajo del pensamiento que nos evita el desgaste de energía al pensar y con la que emitimos rápidas respuestas ante la demanda de un entorno. La reacción más longeva en la historia de la supervivencia del homo sapiens ha sido correr del peligro antes que recopilar datos necesarios para enfrentarlo.

Otra manipulación con impunidad en momentos de elección política popular se genera en las búsquedas por Internet de candidatos que los expertos han denominado 'efecto de manipulación del motor de búsqueda'. Con el algoritmo de búsqueda se manipulan las clasificaciones de los resultados en las bases de datos, mostrando preferencias que benefician y/o afectan a los diferentes candidatos políticos y, por supuesto, generan impacto significativo ante las decisiones de los votantes. Al respecto Robert Epstein y Ronald Robertson, del Instituto Americano del Comportamiento, Investigación y Tecnología de California, realizaron 5 experimentos controlados aleatorios, con doble ciego, con un total de 4.556 votantes indecisos quienes representaban diversas características demográficas de las poblaciones votantes de Estados Unidos e India. Sus resultados demostraron que el sesgo de clasificación de la búsqueda puede cambiar las preferencias del voto en los ciudadanos indecisos en 20% o más y que ese sesgo de clasificación puede ser enmascarado para que la gente no sea consciente de la manipulación.

Una segunda consecuencia de la manipulación con impunidad es que se aumenta la familiaridad de algunos candidatos políticos para inducir mayor credibilidad. Para Georgios Abakoumkin, de la Universidad de Thessaly (Grecia), su investigación examinó la relación entre las preferencias de elección y dos claves periféricas: “el orden de presentación y la familiaridad”. La evidencia relevante condujo principalmente al denominado efecto de primacía, es decir los primeros candidatos en la lista de resultado de la búsqueda tenían ventaja sobre los candidatos mostrados posteriormente pero la familiaridad del político en las preferencias de voto parecía bastante limitada.

Finalmente, una tercera proposición apodíctica sentencia que la manipulación se ejecuta a través de sutiles estrategias de influencia que generan sesgos cognitivos. Estos reducen nuestro pensamiento crítico. Con la influencia del algoritmo, el comportamiento humano pasa desapercibido y lleva a las personas a sentir que han tomado una decisión libre, aunque estén actuando en contra de sus propios intereses.