Un grupo de 52 expertos de alto nivel de la Comisión Europea ha interactuado con base en el compromiso regional de «Unida en la diversidad» para definir la fiabilidad de los sistemas de Inteligencia Artificial (IA) centrados en las personas, maximizando los beneficios y minimizando sus riesgos

“… la definición es una relación entre el sistema y el entorno”. Niklas Luhmann

|

Haga click para ampliar imagen |

Agentes protagonistas de trabajos de desarrollo para el entorno de la informática se están preocupando por el descontrol de las máquinas que deciden por los humanos y generan posibilidades de amenazas. El fundamental asunto que se expone es si con la Inteligencia Artificial (IA) hay futuro humano para disfrutar de modo floreciente.

Cerca de 1.750 desarrolladores informáticos del mundo han estado firmando una carta abierta, hospedada en el sitio Web del Future of Life Institute, con la cual hacen un “llamado a todos los laboratorios de IA para que todos los actores clave pausen inmediatamente, de modo público y verificable, durante al menos 6 meses, el entrenamiento más potente de estos sistemas GPT-4” (un modelo de lenguaje lanzado en marzo 14 de 2023, creado por OpenAI y disponible para los usuarios del ChatGPT Plus).

Bill Gates también se ha sumado pero con un extenso ensayo personal “The age of AI has begun”, hospedado en su blog de notas el anterior marzo 21, donde apunta que “las IA dan respuestas incorrectas a problemas matemáticos porque tienen dificultades con el razonamiento abstracto”. Por supuesto, la máquina digital puede llegar a ser inteligente pero en esencia es estúpida ya que no contextualiza ni reflexiona sobre las consecuencias de las consecuencias de los actos.

Aprovecha el escrito para ampliar el inventario de conflictos clave hacia la mejora de la educación −al menos en Estados Unidos− que ahora genera inequidad, el cambo climático que puede ser más equitativo y la amenaza que representan los humanos armados con IA. Gates incluye al sector educación y al clima habida cuenta porque se han considerado 3 oportunidades que ofrece la IA fiable: educación de calidad y transformación digital; acción por el clima e infraestructura sostenible; salud y bienestar.

Los desarrolladores informáticos del mundo cuestionan que los “sistemas contemporáneos de IA se están volviendo competitivos para los humanos en tareas generales” y preguntan, en consecuencia: ¿Deberíamos dejar que las máquinas inunden nuestros canales de información con propaganda y falsedad? ¿Deberíamos automatizar todos los trabajos, incluidos los de cumplimiento? ¿Deberíamos desarrollar mentes no humanas que eventualmente podrían superarnos en cantidad, al ser más inteligentes, remotas y reemplazarnos? ¿Deberíamos arriesgarnos a perder el control de nuestra civilización? La serie de inquietudes oscila de lo abstracto a lo concreto del fundamento, realización y evaluación de la IA fiable.

El argumento del pedido a la pausa del trabajo estriba en que se deben “desarrollar e implementar conjuntamente protocolos de seguridad compartidos para el diseño y el desarrollo avanzado de IA, que sean rigurosamente auditados y supervisados por expertos externos independientes”. De manera que “La investigación y el desarrollo de IA se deben reenfocar en hacer que los sistemas potentes y de última generación de hoy en día sean más precisos, seguros, interpretables, transparentes, robustos, alineados, confiables y leales.”

Proponen en la carta abierta que los desarrolladores de IA deben trabajar en simultánea con los “legisladores para acelerar drásticamente el desarrollo de sistemas sólidos de gobernanza a la IA”. Y enumeran algunos mínimos como: autoridades reguladoras nuevas y capaces dedicadas a la IA; supervisores y rastreadores de sistemas de IA con grandes conjuntos de alta capacidad computacional; sistemas de procedencia y de marcas de agua para ayudar a distinguir las fugas reales de las sintéticas y rastrear modelos; ecosistema sólido de auditoría y certificación; responsabilidad por daños causados por IA; financiación pública sólida para la investigación técnica de seguridad de la IA e instituciones bien dotadas para hacer frente a las dramáticas perturbaciones económicas y políticas (especialmente en la democracia) que provocará la IA.

En su rol de filántropo, el magnate Gates tampoco se queda a espaldas y propone tres principios que deben guiar la conversación: tratar de equilibrar los temores sobre las desventajas de la IA por su capacidad de mejorar la vida de las personas; garantizar que las IA se utilicen para reducir la inequidad mediante la financiación confiable y con políticas, gobiernos y filantropía correctas; y, tener en cuenta que solo estamos al comienzo de lo que la IA puede lograr.

Avanzar en los protocolosLa confianza sigue siendo el principal cimiento por el cual se asientan las sociedades, comunidades, economías y el desarrollo sostenible. Es por ello que en abril 25 de 2018 la Comisión Europea definió su COM(2018)237 y en diciembre 7 de 2018 corrigió y amplió su COM(2018)795, luego de recibir observaciones a través del proceso de consulta pública. Este ejemplo fácilmente se puede continuar para la elaboración de políticas públicas, siempre y cuando exista voluntad de quienes componen un gobierno.

Los dos documentos citados contienen la visión europea acerca de la Inteligencia Artificial para apoyarla con una ética, segura y vanguardista «made in Europe». Dicha visión se respalda en tres pilares:

a) incremento de las inversiones públicas y privadas en IA para impulsar su adopción,

b) preparación para los cambios socio-económicos, y

c) garantía de un marco ético y legal adecuado para fortalecer los valores europeos.

Sin embargo, la pregunta clave es ¿cómo se alcanza la fiabilidad en un sistema tecnológico y su desarrollo, pero en especial en las aplicaciones?

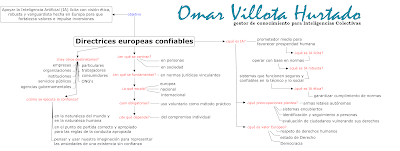

Para el grupo de los expertos europeos convocados hace 5 años, “La IA no es un fin en sí mismo, sino un prometedor medio para favorecer la prosperidad humana y, de ese modo, mejorar el bienestar individual y social y el bien común, además de traer consigo progreso e innovación”. Sin embargo, existen 4 preocupaciones fundamentales que plantea la IA como medio prometedor de beneficio: identificación y seguimiento a personas; sistemas encubiertos; evaluación de ciudadanos vulnerando sus derechos fundamentales y armas letales autónomas.

La clave para “desarrollar e implementar protocolos conjuntos de seguridad compartidos” está ligada a que “los beneficios de esa tecnología IA estén acordes con los valores europeos fundacionales: respeto de los derechos humanos, democracia y estado de Derecho.”

Nosotros los destinatarios

Las directrices éticas de la Comisión Europea se centran en las personas y en las sociedades, precursores merecedores de una IA lícita, ética y robusta al utilizar los sistemas de la IA fiable. Todos nosotros, entonces, podemos optar voluntariamente por usar las directrices como método práctico de cada compromiso individual, considerando la lista de chequeo a la evaluación y la estructura de gobernanza en el rol de consumidores de información digital.

Enumero algunas preguntas para la gestión de la privacidad y de los datos personales, acción prominente del usuario del entorno informático digital. El marco europeo invita a ponerlo en práctica, en modo piloto. ¿Ha tomado medidas para mejorar su privacidad, por ejemplo a través de procesos como el encriptado, la anonimización y la agregación? ¿Se ha pronunciado con consentimiento válido y posibilidad de revocar el uso de sus datos personales, cuando proceda? ¿Ha instaurado procesos para garantizar la calidad y la integridad de sus datos? ¿Cómo está verificando que los conjuntos de sus datos no son vulnerados ni son objeto de ataques? ¿Ha evaluado quién puede acceder a sus datos de usuario y en qué circunstancias? ¿Se ha asegurado que esas personas poseen la cualificación para acceder a sus datos y que cuentan con competencias necesarias para comprender los detalles de la política de protección de datos? ¿Se ha asegurado que exista un mecanismo de supervisión que permita registrar cuándo, dónde, cómo y quién accede a sus datos, y con qué propósitos?

Además, la lista de destinatarios de la Comisión Europea involucra a empresas, organizaciones, investigadores, servicios públicos, agencias gubernamentales, instituciones, organizaciones de la sociedad civil, particulares, trabajadores y consumidores. Por tanto las preguntas se amplían a cada rol del repertorio.

De otro lado, el conjunto de agentes que contribuye a entregar desarrollo y despliegue de los sistemas de la IA fiable estará conformado por “las cualidades de los sistemas socio-técnicos, que abarcan: personas, agentes estatales, corporaciones, infraestructura, programas informáticos, protocolos, normas, gobernanza, leyes existentes, mecanismos de supervisión, estructuras de incentivos, procedimientos de auditoría, informes sobre buenas prácticas, etc.”

Finalmente, la Comisión Europea define la IA lícita como el operar con base en normas jurídicamente vinculantes a escala europea, nacional e internacional por cuanto establecen obligaciones que significan lo que no se puede hacer y lo que se debe hacer; IA ética que implica garantizar que se cumplan las normas éticas; y IA robusta mediante sistemas que deben funcionar de manera segura y fiable en lo técnico y en lo social, previendo medidas de protección para evitar cualquier efecto adverso imprevisto.

Desde la teoría de la complejidad social planteada por el sociólogo alemán Niklas Luhmann se deben dar 3 condiciones para que opere la confianza, “en el más amplio sentido de la fe en las expectativas de uno”: i) sentar la confianza en la naturaleza del mundo, que es evidente por sí misma, y en la naturaleza humana. De modo que “la confianza es una parte integral de los límites dentro de los cuales vivimos”; ii) “el punto de partida correcto y apropiado para la derivación de reglas para la conducta apropiada” consideraría la necesidad de confianza. Con este método se llega a las máximas éticas, entendidas como “principios que son inherentemente reversibles y de valor cuestionable”; y iii) “pensar y usar nuestra imaginación para representar las ansiedades de una existencia sin confianza”. Habida cuenta, el análisis funcional no consiste en establecer las conexiones entre datos establecidos o conocimiento confiable a través del cual se obtiene conocimiento adicional, en consecuencia.

Siguiendo con el hilo de la teoría de Luhmann, la confianza es personal dado que “no se puede confiar en el caos, ya que si nada se conecta con nada o todo con todo, es imposible construir generalizaciones”. Por tanto, es mediante la libertad de acción que poseemos los seres humanos −como sistema de tipo especial− que surge en el mundo el aumento de la complejidad y donde se centra la confianza, que se extiende a otro ser humano antes que nada.

Para el sociólogo alemán, entonces, “la confianza es la expectativa generalizada que el otro manejará su libertad para la acción diversa, manteniendo su personalidad que ha mostrado y hecho socialmente visible”. Aún así, toda forma perceptible de comportamiento es comunicación que requiere algún tipo de salvaguarda.

Por su parte, el lingüista norteamericano, Noam Chomsky, en entrevista con el blog Tehran Times respondía en marzo 24 pasado que “ la distinción fundamental entre lenguaje y mente sigue siendo un tema de debate filosófico … Y, si bien las máquinas pueden volverse más hábiles en el procesamiento del lenguaje, su diseño revela que es un plagio de alta tecnología en esencia”.