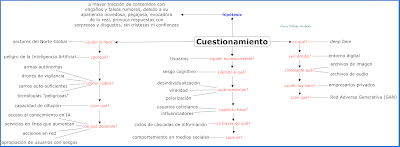

Sectores del Norte Global cuestionan si las tecnologías ‘peligrosas’, impulsadas bajo inteligencia artificial, son tendencia del mercado de los insumos

La tecnología para crear contenido deep fake (falsificación profunda) está en la vanguardia de la actual suplantación digital debido al aprovechamiento de los algoritmos con base en el aprendizaje automático y en la creación de imitaciones realistas.

Para llevar a cabo la falsificación profunda se inserta primero tanto caras como voces de personas en grabaciones de video y de audio. El resultado, por tanto, es la emulación realista que alguien hizo o dijo algo, sin su consentimiento, y obvio, el contenido es una falsedad. Asegurar la difusión, el incremento de la viralidad y el enganche del mensaje es cuestión de responsabilidad del usuario de las plataformas de medios sociales.

Durante el desarrollo del tratamiento de imágenes, entiéndase ensamble de iluminación, aplicación de filtros, etc. la tecnología ha estado presente mejorando la calidad de la puesta en escena. La cuestión, ahora, es que esa diligencia tecnológica no es inocua pues se hace con el acérrimo propósito de modificar las imágenes, de forma superficial y sustantiva. La galería “Photo Tampering Throughout History” almacena colecciones de fotografías manipuladas, por ejemplo. Hasta ese campo visual ha llegado la ciencia forense digital para enfrentar el desafío de desenmascarar la alteración.

En archivos de audio también existen convincentes modelos deep fake. Una lista rápida puede incluir “Wavenet” de Google DeepMind, “DeepVoice” de Baidu, entre otros. No obstante, la oralidad está libre de detecciones pero el aprendizaje automático promete capitalizar el fraude.

Modelos de tecnología para originar deep fake están a la vista de quien rastree a través de un motor de búsqueda con el keyword Gan: “redes adversas generativas”. Este enfoque ingeniado por Ian Goodfellow, investigador de Google, trabaja con dos redes neuronales simultaneas: la generadora que produce una muestra desde un conjunto de datos para imitar y la otra, discriminadora que evalúa iterativamente el grado de éxito de imitación de la red generadora. Ninguna de las dos se agobia, ambas superan en velocidad, escala y variedad lo que podrían hacer los supervisores humanos.

Todo este conjunto de falsificación profunda es originado por empresarios privados, pues por el momento “no hay subvenciones de la National Science Foundation que otorguen dólares federales a los investigadores por estudiar la detección del contenido manipulado en video y en audio”, sostienen Bobby Chesney y Danielle Citron, profesores investigadores de Derecho en University of Texas School of Law y Boston University School of Law, en su orden. De manera que el peligro frente a la defensa y los usos hostiles está latente si se desecha la ética durante la creación o modificación del algoritmo y, sobre todo, por su rápida democratización.

El Futuro de la tecnología de violencia

Con lo visto en el desmedido encierro y en la extremista inmovilización social, la pandemia pública (o mejor, sindemia) en salud-economía imputada al Covid-19, algunos sectores del Norte Global han cuestionado si las tecnologías ‘peligrosas’, impulsadas bajo inteligencia artificial, tales como armas de fuego autónomas o drones para vigilancia o automóviles autosuficientes, que libremente se venden al público a precios modestos, son tendencia del mercado de los insumos suficientes. El motivo destacado es que el mercado de los insumos escasos -como el conocimiento- es de obligada restricción. Esa difusión del peligroso deep fake se gesta si y solo si la tecnología está construida para funcionar y, por ahora, funciona debido a que no es un recurso intangible, como la información.

La capacidad de difusión de la tecnología deep fake depende de

- acceso al campo de los conocimientos enfocados hacia el aprendizaje automático,

- los servicios encausados a través de herramientas sencillas de usar que aumentan, se implementan y se propagan en línea,

- las acciones en red que apropian los usuarios mediante el usual sesgo cognitivo.

Sesgo cognitivo

Comportamientos de los usuarios frente a la información en línea y la conectividad ubicua global ocasionan problemas tales como: desindividuación, viralidad y polarización de grupos. Esta cultura digital ha trastocado el viejo modelo de la distribución del contenido centralizado por medios masivos del tipo cadenas de televisión y de radiodifusión, periódicos, revistas y editoras de libros. Esos magnates controlaban la difusión de la información además de influir prominentemente en sus audiencias. Otra porción de responsabilidad está en manos de los usuarios influenciadores (inflamadores, ¿sería mejor?) de medios sociales que amplifican aún más la información en línea con base en tres acciones: la dinámica “cascada de información”, la extensión “filtros de burbuja” y la atracción humana “cámaras de eco” hacia la información negativa y novedosa.

David Easley y Jon Kleinberg exploran desde 2007 los sesgos cognitivos en el mercado de la información. Para estos académicos la “cascada de información” es el comportamiento común en los medios sociales, resultado de cuando las personas dejan de prestar suficiente atención a su propia información y, en cambio, confían en lo que asumen otros y luego transmiten esa información ajena. El sociólogo alemán, Niklas Luhmann, ya en 1966, hablaba de la confianza como problema de la complejidad social (el leit motiv es que nunca se leyó).

El ciclo de la dinámica “cascada de información” es vicioso pues en la medida que el bucle se repite -“creo, confío y propago lo que el otro me envía”- se fortalece hacia una catarata. Existen repetitivos y recientes ejemplos: las manifestaciones contra la Ronda del Milenio en 1999 conocidas como “la batalla de Seattle”, los manifestantes de la Primavera Árabe iniciada en 2010 que difundieron videos y fotografías de la tortura policial, el hashtag #BlackLivesMatter de 2013 difundido por activistas afroestadounidenses, las acciones encubiertas de Rusia durante la elección presidencial norteamericana del 2016, el movimiento Never Again de 2018 liderado por estudiantes sobrevivientes del tiroteo en la escuela secundaria Stoneman Douglas de Parkland (EE. UU.) y más actualmente, los más de 50 videos publicados en redes sociales que Human Rights Watch corroboró ante los abusos cometidos por la brutalidad policial de Colombia contra manifestantes en 2021.

Otra capacidad en la cultura del usuario en red es el “filtro de burbuja”, que agrava aún más la difusión de la información falsa. Consiste en la acumulación de respaldos y de acciones que incrementan las posibilidades del algoritmo. Es decir, las personas después de ver en línea recomendaciones de ‘amigos’ tienden a transferir esas influencias a sus propias redes debido a la tendencia humana de compartir la información con la que se está de acuerdo para confirmar sus creencias preexistentes, incluso sin la ayuda de la tecnología.

Un ejemplo a favor de los “filtros de burbuja” fue reseñado en la investigación de los politólogos, Andrew Guess, Brendan Nyhan y Jason Reifler, quienes midieron la producción y el consumo de noticias falsas en Facebook durante las elecciones presidenciales de EE. UU. del 2016. Ellos encontraron que quienes leyeron los artículos etiquetados con fact-checking (verificación de hechos) antes de haber consumido originalmente fake news no tuvieron problema pero quienes consumieron sin dudar noticias falsas casi nunca leyeron la verificación de hechos ya que podría desacreditarlos.

La tendencia humana por la atracción de lo negativo, incluida la información mediada, ha sido objeto de estudio de científicos de los datos. En 2010, Soroush Vosoughi, profesor asistente de ciencias de la computación de Dartmouth; Deb Roy, director del grupo Máquinas Cognitivas de MIT; y Sinan Aral, profesor de Gestión, IT, Marketing y Ciencias de Datos del MIT, estudiaron 126.000 mensajes compartidos en Twitter, entre 2006 a 2010. Usaron sitios de terceros de verificación de datos para clasificarlos como verdaderos o falsos. La conclusión fue que rumores engañosos y falsos llegan a la gente diez veces más rápido que las historias precisas. Incluso al controlar esas diferencias entre las cuentas originadoras de los falsos rumores, la falsedad obtuvo 70 por ciento más probabilidad de ser retuiteada que la información precisa.

La hipótesis científica por tanto es que el engaño y los falsos rumores tienen mayor tracción debido a que parecen más novedosos, son pegajosos, evocan lo real y provocan respuestas que expresan sorpresa y disgusto. Por su parte, las historias precisas ocasionan respuestas asociadas con tristeza y confianza.

¿El futuro se tornará más violento usando la tecnología cuyo algoritmo informático, también de creación humana, se construye soportado en el aprendizaje profundo para difundir información negativa o falsa novedad? y cuando no aparece un cerebro pensante que escribe acerca del entorno real lo ocupa un bot que estimula y aumenta de manera automática la propagación de la información falsa y la falsificación profunda.